Manipulieren Lernen durch Demonstration (aus einem Raum entkommen)

© RBO

© RBO

Kontaktpersonen

Projektbeschreibung

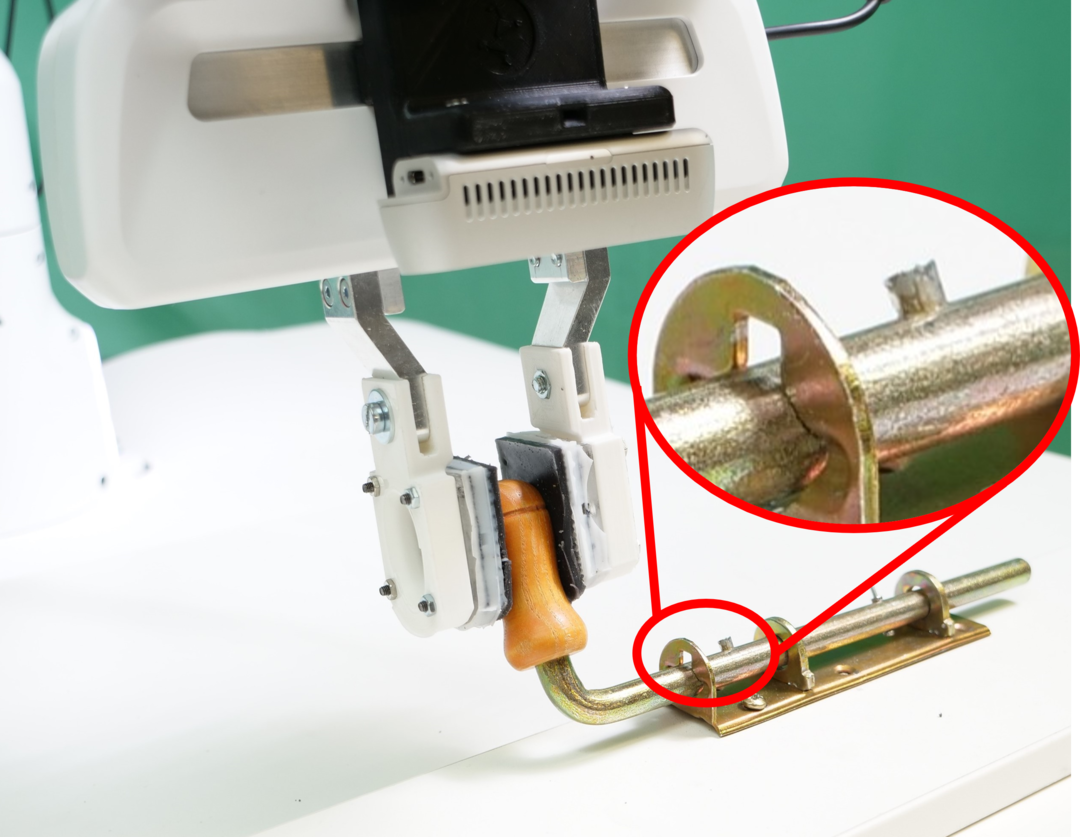

Wir werden einen neuartigen Ansatz für das Lernen durch Demonstration entwickeln, um einem Roboter komplexe, kontaktreiche Manipulationsaufgaben beizubringen. Dieser Ansatz wird es den Robotern ermöglichen, komplexe Schlösser und andere Mechanismen physisch zu bedienen. Die wissenschaftliche Herausforderung besteht in der zuverlässigen Bedienung solcher Mechanismen mit mehreren Freiheitsgraden, die Übergänge zwischen verschiedenen Mehrfachkontaktsituationen erfordern. Anstatt diese Manipulationen direkt zu programmieren, wird ein Mensch dem Roboter die Bewegungen vorführen. Wir werden unser Wissen über das Problem und eine clevere Methode zur Erkennung des Demonstrationsverhaltens nutzen, um robuste und übertragbare Manipulationsstrategien zu entwickeln. Diese Strategien werden einen wichtigen Baustein für einen der SCIoI-Demonstratoren bilden, bei dem ein mobiler Manipulator aus einem Escape Room entkommen muss. Um den vorgeschlagenen Ansatz des Lernens aus Demonstrationen zu entwickeln und zu validieren, werden wir Escape Rooms mit zunehmender mechanischer Komplexität konstruieren und die neu gestellten Herausforderungen mit weiteren Fortschritten in unserem Ansatz abgleichen.

Learning from Demonstration Based on Environmental Constraints

Bitte beachten Sie: Sobald Sie sich das Video ansehen, werden Informationen darüber an YouTube/Google übermittelt. Weitere Informationen dazu finden Sie unter Google Privacy.

Programmieren durch Vormachen wurde erfolgreich auf verschiedene Manipulationsaufgaben angewendet, z.B. Aufnehmen und Platzieren, Wasser gießen und so weiter. Diese Lernalgorithmen versuchen oft, Manipulationsstrategien abzuleiten, die niedrige Demonstrationshandlungen, Trajektorien oder Bewegungsmerkmale reproduzieren. Jedoch führen in dem Kontext von kontaktreichen Manipulationen kleine Fehler, die aus Bewegungs- und Wahrnehmungsungenauigkeiten resultieren, zu drastisch großen Reaktionskräften und verursachen dadurch Manipulationsfehler. Als Folge sind die Strategien, die sich auf niedrige Handlungen konzentrieren, ohne die Umgebung zu berücksichtigen, oft brüchig in kontaktreichen Szenarien und leiden unter der Generalisierung zu Umweltveränderungen.

Um dieses Problem zu überwinden, haben wir erkannt, dass Environmental Constraint (EC) eine angemessene Darstellung ist. Statt niedrige Demonstrationshandlungen nachzuahmen, zielt unser Ansatz darauf ab, die gleichen UBs, die in der Demonstration präsent sind, zu replizieren. Da UBs über verschiedene Objektinstanzen desselben Typs invariant bleiben, ist unsere Politik in der Lage, effektiv zu generalisieren. Zusätzlich, durch das Nutzen von UBs mit kompatiblen Controllern, um die negativen Auswirkungen von Unsicherheiten zu mildern, werden unsere Politiken robuster.

Augmentation To Complete Environmental Constraints in Demonstrations

Bitte beachten Sie: Sobald Sie sich das Video ansehen, werden Informationen darüber an YouTube/Google übermittelt. Weitere Informationen dazu finden Sie unter Google Privacy.

In der zweiten Phase erkennen wir eine wichtige Tatsache, dass menschliche Demonstrationen nicht immer genügend Informationen über ECs enthalten, die extrahiert werden können. Dies liegt daran, dass Menschen, wenn sie mit der Manipulationsaufgabe vertraut sind, viel weniger Interaktion mit der Umgebung aufweisen, was zu unzureichenden Informationen führt, damit Roboter ECs nachvollziehen können. Um dieses Problem zu überwinden, haben wir einen neuartigen LfD-Ansatz entwickelt, der eine Demonstration durch Erweiterung vervollständigt, um die notwendigen Informationen über UBs zu erhalten. Spezifisch nutzen wir die präzise Propriozeption moderner Roboter und spielen dann eine beobachtete Demonstrations-Trajektorie erneut ab, um aktiv zu erkunden und die umgebenden ECs zu erschließen.

Förderung

Dieses Projekt wird von der Deutschen Forschungsgemeinschaft (DFG) im Rahmen der Exzellenzstrategie - EXC 2002/1 "Science of Intelligence" - Projektnummer 390523135 gefördert.

Publications

2023

Augmentation Enables One-Shot Generalization In Learning From Demonstration for Contact-Rich Manipulation

Proceedings of the IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS)

2023

2022

Learning From Demonstration Based on Environmental Constraints

IEEE Robotics and Automation Letters, 7 (4) :10938-10945

2022

2020

Driving Style Encoder: Situational Reward Adaptation for General-Purpose Planning in Automated Driving

2020 IEEE International Conference on Robotics and Automation (ICRA), Seite 6419-6425

2020

Planning on the fast lane: Learning to interact using attention mechanisms in path integral inverse reinforcement learning

2020 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS), Seite 5187-5193

2020